Esto quiere decir que independientemente del sistema operativo que usemos, funcionará. Da igual qué tecnología usemos, XML lo entenderá y cualquier intérprete lo reproducirá sin mayor problema.

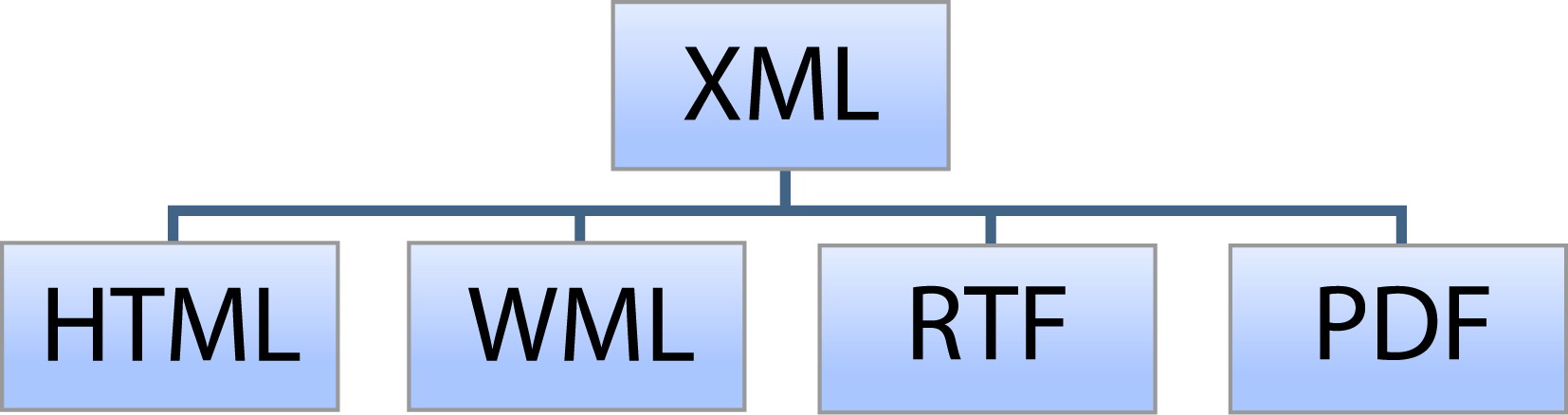

Aparte de su gran utilidad, hay que mencionar su maleabilidad y personalización. Pues a a pesar de parecer HTML con esteroides (al fin y al cabo se trata de un derivado del SGML, padre del HTML), tiene la posibilidad de que cada persona cree su propio lenguaje de etiquetas. Esto puede convertirse en un problema a la hora de trabajar en equipo, o de exportar/importar documentos. Para paliar esto tenemos dos estándares, las DTD's y los XML Schemas, que concretan sus posibles declaraciones.

En nuestra Ciencia de la Información, y concretamente en el tratamiento de datos, es algo a tener en cuenta. Ya que existen muchos sistemas distintos que tienen que comunicarse entre sí. Dentro de cualquier empresa, incluso una biblioteca o archivo, tiene varios departamentos que al realizar actividades distintas, generan distinta documentación, datos financieros, texto sobre clientes o socios, nóminas, etc. Pero esa información hay que enviarla entre departamentos, cruzarla y gestionarla. Y para ello, el XML los une a todos y consigue que se entiendan.

Además sigue siendo en el fondo texto plano, y sólo el texto es indizable por una base de datos para su posterior recuperación. Me explico, por ejemplo Google usa unos bots que recorren la red, indizando las páginas para luego poder recuperarlas, si éstas no tienen texto plano, los bots no las pueden leer.

Aparte de esto, XML nos facilita a nosotros el poder catalogar o archivar documentos digitales, así como páginas web. HTML no entendía de estructuras, pero con XML y la creación del EAD esto ya no es problema.

Además sigue siendo en el fondo texto plano, y sólo el texto es indizable por una base de datos para su posterior recuperación. Me explico, por ejemplo Google usa unos bots que recorren la red, indizando las páginas para luego poder recuperarlas, si éstas no tienen texto plano, los bots no las pueden leer.

Aparte de esto, XML nos facilita a nosotros el poder catalogar o archivar documentos digitales, así como páginas web. HTML no entendía de estructuras, pero con XML y la creación del EAD esto ya no es problema.